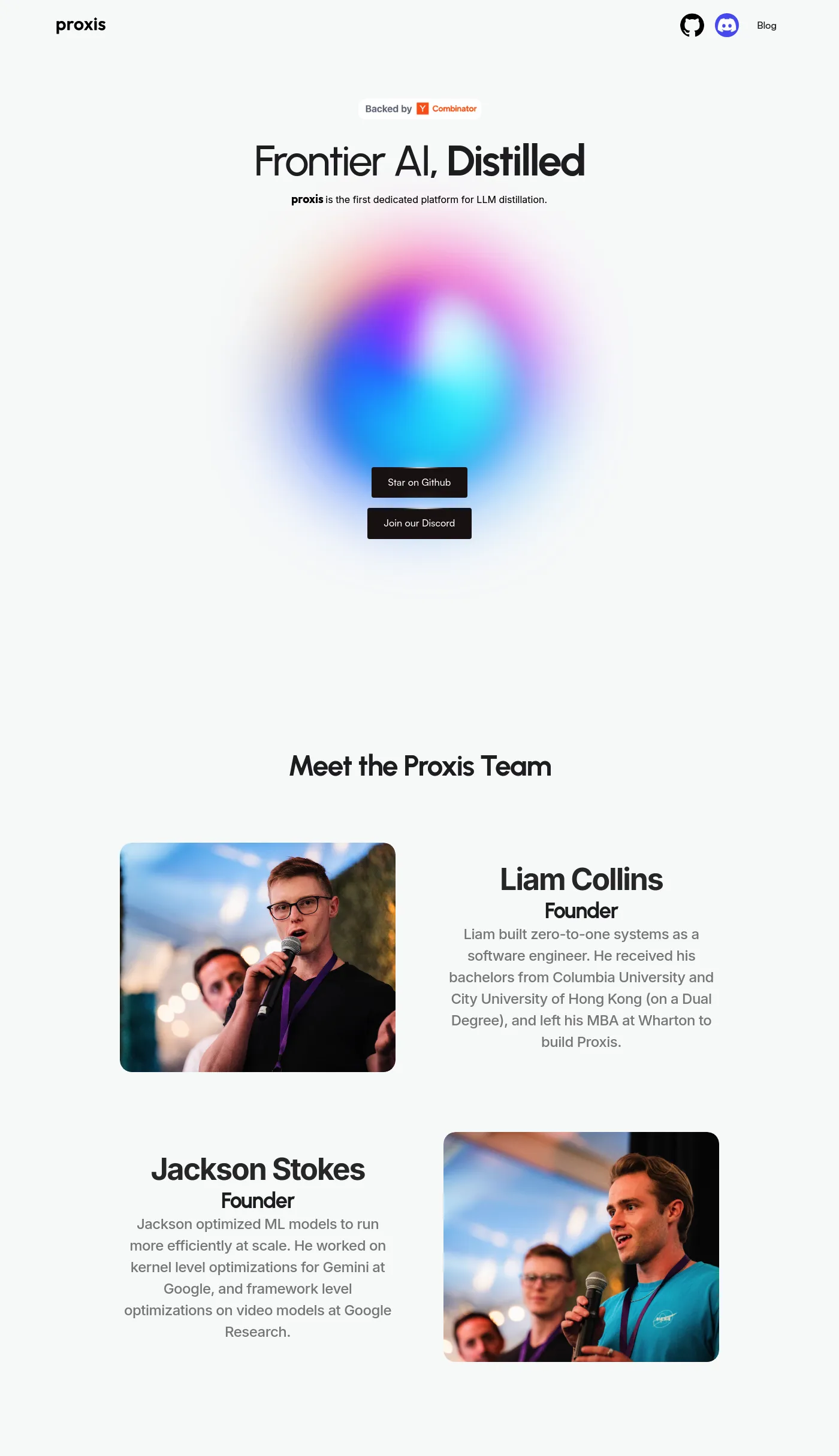

Proxis は、LLM 蒸留と提供のための最初の専用プラットフォームであり、1/10 のコストで本番環境対応のモデルを実現します。Google で Gemini モデルの最適化を行った Jackson(CTO)と、ソフトウェア エンジニアとしてゼロからワンまでシステムを構築した Liam(CEO)が開発しました。Proxis を使用して、最先端の Llama 405b を独自のデータでチューニングされた効率的なモデルに蒸留できます。これにより、閉鎖型ソースの代替手段と比べて 5 倍速く、10 倍安価になります。

プロキシスを使用すると、パフォーマンスを犠牲にすることなく、大規模言語モデル(LLM)を小さく、高速なモデルに変換できます。高いパフォーマンスを実現するために構築されたプロキシスは、使いやすさに重点を置いています。

モデル開発者、AI研究者、LLMを効率的に展開したいスタートアップや企業。