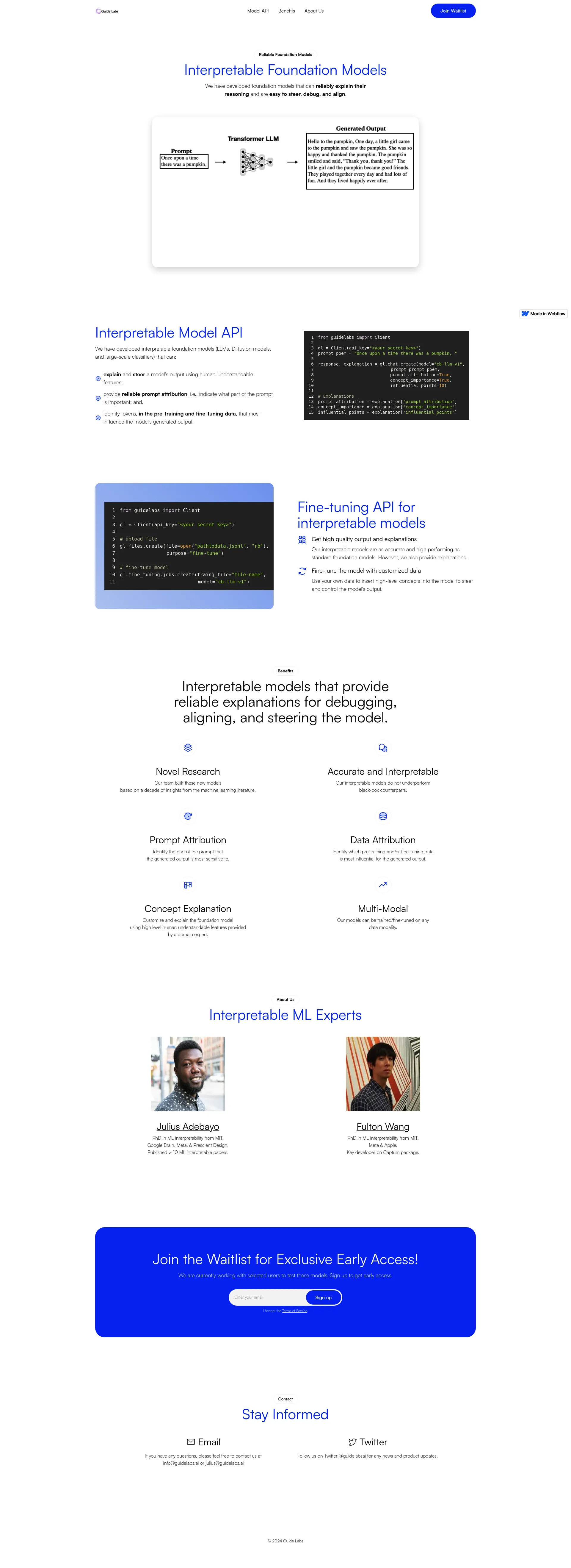

在指南实验室,我们构建可解释的基础模型,这些模型可以可靠地解释其推理,并且易于对齐。我们通过 API 提供对这些模型的访问。在过去的 6 年中,我们的团队在 Meta 和 Google 构建和部署了可解释的模型。 我们的模型提供以下解释: 1) 为每个输出 token 提供人类可理解的解释, 2) 确定输入(提示)的哪些部分对生成的输出的每个部分最为重要,以及 3) 训练数据中的哪些输入直接导致模型生成的输出。 由于我们的模型可以解释其输出,因此它们更易于调试、引导和对齐。

指南实验室提供灵活的定价计划,以满足不同的需求。请联系我们获取详细的定价信息和定制计划。

指南实验室由机器学习可解释性的专家领导:

加入我们的候补名单,获得我们可解释的基础模型的独家抢先体验。

与志同道合的专业人士进行一对一对话

从 Slack 混乱到清晰,只需几分钟

在不到 30 分钟的时间内个性化数千个着陆页

首个用于文档解析的 LLM,兼具准确性和速度

面向 SaaS 专业人士的 AI 助手

带实时翻译功能的 AI 电话应用程序

令人愉快的 AI 支持的互动演示—现在无需登录

AI 动态图形副驾驶

抛洒彩带,摆脱压力和焦虑,100% 无需人工智能

SaaS 的顺畅支付