Tensorfuseは、独自のクラウドにLLMパイプラインをデプロイして管理することを容易にします。クラウドをTensorfuseに接続し、モデルを選択し、データにポイントし、デプロイをクリックするだけです。Tensorfuseが、基礎となるインフラストラクチャをプロビジョニングして管理します。 裏側では、K8s + Rayクラスターを管理しており、LLMOpsオーバーヘッドなしでスケーリングできます。

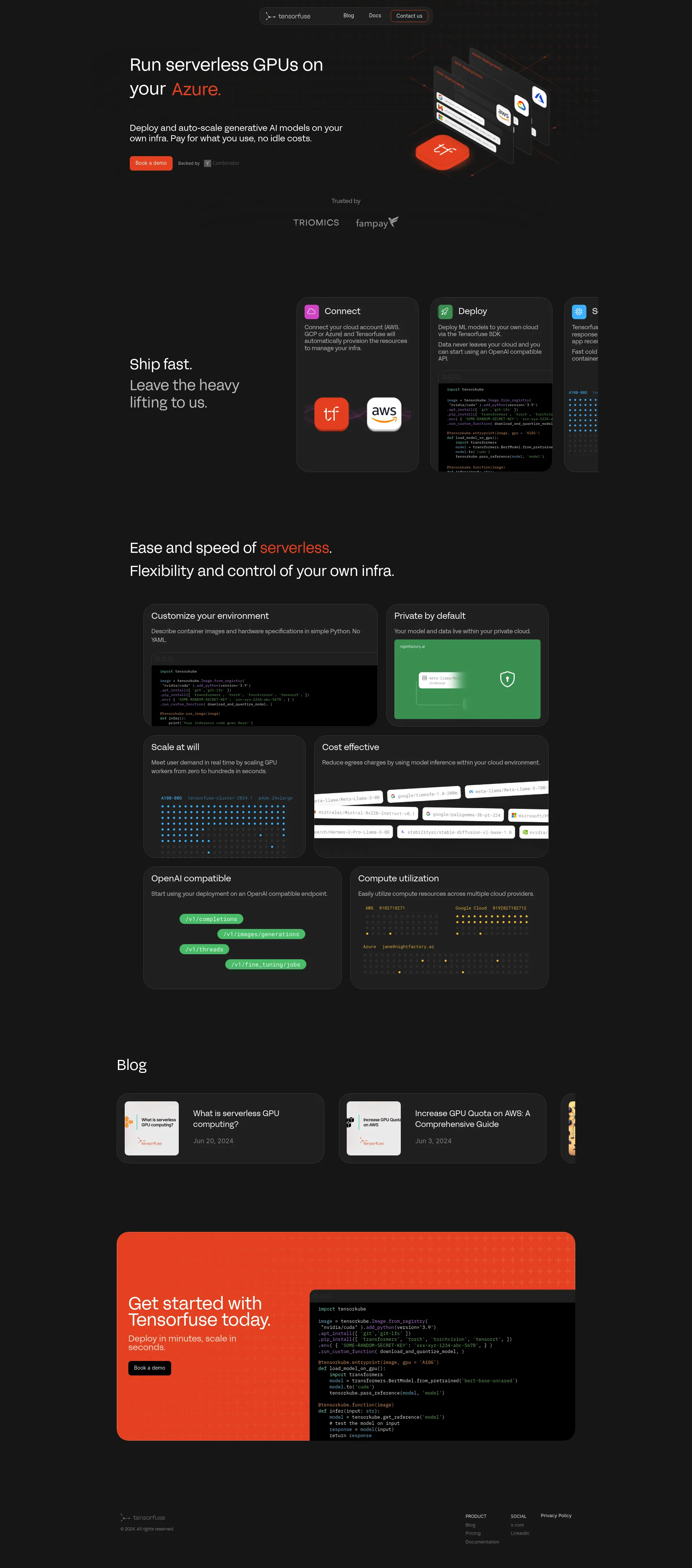

Tensorfuse を使用して、独自のインフラストラクチャに生成AIモデルをデプロイして自動スケーリングします。プライベートクラウドの柔軟性と制御を維持しながら、サーバーレスコンピューティングの利便性と速度をお楽しみください。使用した分だけお支払いください。アイドルコストはかかりません。

無料レベル: $0 + コンピューティング管理コスト

チーム: $150 + コンピューティング管理コスト

エンタープライズ: カスタム

Tensorfuseは、小さなスタートアップから大企業まで、あらゆる規模のチームをサポートするように設計されています。柔軟な価格設定とスケーラブルなインフラストラクチャにより、インフラストラクチャの制限を心配することなく成長できます。Tensorfuseを今すぐ始めましょう。数分でデプロイし、数秒でスケーリングします。TensorfuseがどのようにAIデプロイメント戦略を変革できるかをご覧ください。

AIを使用してソフトウェアを構築するための統合されたDevOpsプラットフォーム。

LLM のファインチューニングと推論のための高速でスケーラブルなインフラストラクチャ。

プロンプトを最高のLLMにルーティングしましょう ✨

AI用データベース

非 AI 開発者向けのオープンソース AI 支援 LLM 微調整ライブラリ

すべての生産ニーズに対応するフルスタック LLMOps プラットフォーム

MLモデルを実行およびデプロイするための低レイテンシAPI

Google、Notion、メールのデータを LLM に接続

志を同じくするプロフェッショナルと 1 対 1 の会話でマッチング

Slackの混沌から明瞭さへ、わずか数分で

30分以内に何千ものランディングページをパーソナライズ

正確さと速度を備えたドキュメント解析のための最初の LLM

SaaS専門家向けのAIアシスタント

ライブ翻訳機能付きAI搭載電話アプリ

魅力的な AI 搭載のインタラクティブなデモ—今すぐログイン不要

AI モーショングラフィック副操縦士

ストレスと不安を取り除くためにコンフェティをポップしましょう、100%AIフリー

SaaSのためのスムーズな支払い